Deepfake teknolojisi uzun süredir gündemde olsa da 2025, yapay zeka destekli içeriklerin "ilginç bir teknolojik gelişme" olmaktan çıkıp günlük iş süreçlerini tehdit eden operasyonel bir riske dönüştüğü yıl oldu. Artık sadece siyasi manipülasyon veya ünlülerin hedef alındığı taciz içerikleri değil, işe alım süreçlerinden bankacılık sistemlerine, çağrı merkezlerinden kurumsal iletişime kadar pek çok alanda sentetik medya kaynaklı dolandırıcılık ve güven erozyonu yaşanıyor.

Siber güvenlik şirketi Reality Defender'ın 2025 sonunda yayınladığı "Defending Reality (Gerçekliği Savunmak)" raporu, bu tür aldatmaların artık şirketler, hükümetler ve bireyler için sistemik bir tehdit haline geldiğini ortaya koyuyor.

Nasıl bu kadar yaygınlaştı?

Eskiden deepfake üretmek için ileri düzey teknik bilgi ve güçlü donanım gerekiyordu. Günümüzde herkes birkaç dakika içinde kullanıma hazır yazılımlarla ikna edici ses veya video üretebiliyor. Derin öğrenme algoritmalarındaki gelişmeler, sentetik içerikleri gerçeğinden ayırt etmeyi neredeyse imkansız hale getirdi.

Bu demokratikleşme beraberinde ciddi riskler getirdi. Kimlik hırsızlığı, itibar zedelenmesi ve hedefli taciz gibi bireysel tehlikelerin ötesinde, deepfake'ler artık finansal dolandırıcılık, piyasa manipülasyonu, kurumsal casusluk ve son derece etkili sosyal mühendislik saldırılarının aracı haline geldi.

2025’te deepfake tehdidi büyüdü

Yıl boyunca yaşanan bir dizi olay, deepfake tehdidinin boyutlarını gözler önüne serdi.

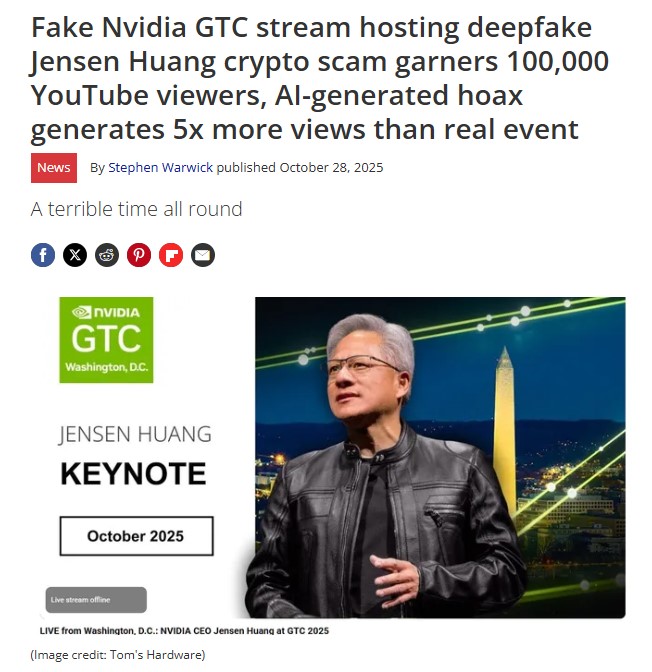

NVIDIA'nın konferansı sırasında YouTube'da yayınlanan sahte bir canlı yayında, şirketin CEO'su Jensen Huang'ın deepfake versiyonu bir kripto para dolandırıcılığını tanıtıyordu. Sahte yayın zirvede 95 bin izleyiciye ulaşırken, gerçek yayını yalnızca 12 bin kişi izliyordu.

ABD'de bir dolandırıcı, Dışişleri Bakanı Marco Rubio'yu taklit eden yapay zeka üretimi ses mesajları ve metinlerle üst düzey hükümet yetkililerine ulaşmayı başardı. Dijital adli tıp uzmanı Hany Farid'in Washington Post'a söylediği gibi, bu tür bir operasyon için yalnızca 15-20 saniyelik ses kaydı yeterli olabiliyor.

İşe alım alanında ise yaklaşık 900 işe alım uzmanıyla yapılan bir araştırma çarpıcı sonuçlar ortaya koydu: Katılımcıların yüzde 72'si yapay zeka ile üretilmiş özgeçmişlerle, yüzde 51'i yapay zeka ile oluşturulmuş iş örnekleriyle, yüzde 15'i ise iş görüşmeleri sırasında gerçek zamanlı yüz değiştirme teknolojisiyle karşılaştığını bildirdi.

Beş kritik tehdit alanı

Reality Defender raporu, 2026'da kuruluşların acil eylem gerektiren beş deepfake senaryosunu tanımlıyor.

- Sahte yönetici aramaları

Ses klonlama teknolojisi, üst düzey yöneticilerin ses tonunu, konuşma ritmini, aksanını ve sözlü alışkanlıklarını şaşırtıcı bir doğrulukla kopyalayabiliyor. Tek bir telefon görüşmesinde sahte bir CFO, havale talimatı verebilir, gizli finansal veriler talep edebilir veya yüksek riskli bir işlemi onaylayabilir. Hong Kong'da dolandırıcılar, bir finans yöneticisinin sesini klonlayarak yaklaşık 18,5 milyon dolarlık bir kripto para dolandırıcılığı gerçekleştirdi.

Geleneksel oltalama saldırılarına karşı farkındalık eğitimleri, çalışanları şüpheli e-postaları tespit etmeye hazırlıyor, ancak patronlarının sesinden ayırt edilemeyen sentetik seslere karşı savunmasız kalıyorlar.

- İş görüşmelerinde sahte adaylar

Uzaktan ve hibrit çalışma modelleri video görüşmeleri standart işe alım yöntemi haline getirirken, yeni bir tehdit alanı da ortaya çıktı. Araştırma şirketi Gartner, 2028'e kadar dünya genelinde her dört iş adayından birinin sahte olabileceğini öngörüyor.

Reality Defender, kontrollü bir Zoom görüşmesinde "Gary" adlı bir adayla deneyim gerçekleştirdi. Gary kendinden emin ve profesyonel görünüyordu, ancak aslında gerçek değildi. Gary, yaygın olarak erişilebilen araçlarla on dakikadan kısa sürede oluşturulmuş bir deepfake'ti.

ABD Adalet Bakanlığı'nın son davaları, sentetik adayların yaptırım uygulanan kuruluşlara para aktarmak, hassas sistemlere erişmek ve karanlık ağ pazarlarında satılmak üzere kimlik bilgilerini toplamak için işe alındığını ortaya koydu. Yani gerçek olmayan bir çalışan, tüm bir ağa giriş noktası olabilir.

- Sentetik kimlik dolandırıcılığı

Bankacılık ve fintech sektöründe müşteri tanıma (KYC) süreçleri, yüz tanıma, kimlik yükleme veya canlılık kontrolleri aracılığıyla uzaktan doğrulama yapıyor. Ancak bu kolaylık sağlayan sistemler, saldırganlar için de bir fırsat haline geldi.

Mevcut KYC sistemlerinin çoğu bir yüzün kimlikle eşleşip eşleşmediğini veya bir sesin kayıtlı ses iziyle uyuşup uyuşmadığını doğrulayabiliyor, ancak bu yüzün veya sesin gerçek olup olmadığını doğrulayamıyor. Yapay zeka üretimi medya artık bu sistemlerin dayandığı biyometrik kalıpları taklit edebiliyor ve sentetik kimliklerin güvenlik kontrollerini geçmesine olanak tanıyor.

- Dezenformasyonun hızı

Sınır Tanımayan Gazeteciler'den Vincent Berthier'in belirttiği gibi, deepfake'ler "gazeteciliğe karşı bir silah" haline geldi.

2025'te uçakların Beyrut havalimanına inişini gösteren yapay zeka üretimi görseller,

hava saldırıları hakkında yanlış iddialarla viral oldu. İngiltere'de Muhafazakar Parti milletvekili George Freeman'ın başka bir partiye geçtiğini iddia eden deepfake video,

yalanlanmadan önce geniş çapta yayıldı.

MIT'nin araştırmasına göre yanlış haberler doğru haberlere kıyasla yüzde 70 daha fazla paylaşılıyor ve gerçek haberlerin aynı kitleye ulaşması için altı kat daha fazla zaman gerekiyor. Düzeltme yayımlandığında yanlış bilgi çoktan yayılmış oluyor.

- Çağrı merkezi dolandırıcılığı

Ses doğrulama bir zamanlar güvenilir bir güvenlik katmanıydı. Artık en savunmasız olanlardan biri. Sosyal medya, video görüşmeleri veya podcast'lerden toplanan birkaç saniyelik ses kaydıyla saldırganlar, yöneticilere veya müşterilere özdeş sesler klonlayabiliyor.

Wall Street Journal muhabiri Joanna Stern, kendi sesini klonlayarak bankasının kimlik kontrollerini geçmeyi başardı. Proofpoint'e göre finansal kuruluşların yüzde 99'u hesap ele geçirme girişimleriyle karşılaştı ve yüzde 62'si en az bir ihlal yaşadı.

Tehdit klonlanmış sesin ötesine geçti. Müşteri kolaylığı için tasarlanan otonom yapay zeka ajanları artık menülerde gezinmek, bekleme sırasında kalmak, temsilcilere baskı yapmak ve iptal tehditleri simüle etmek için kullanılabiliyor. Birçok durumda temsilciler gerçek bir müşteriyle mi, klonlanmış bir sesle mi yoksa başka biri adına hareket eden bir yapay zeka sistemiyle mi konuştuklarını ayırt edemiyor.

İş ciddi

Deepfake teknolojisi artık sadece teknoloji meraklılarının veya güvenlik uzmanlarının gündeminde değil. 2025, bu yapay içeriklerin iş dünyasından devlet kurumlarına, medyadan bankacılığa kadar her alanda sistemik bir tehdit oluşturduğunu kanıtladı.

Deepfake tehditleri karşısında en güçlü silah hâlâ eleştirel düşünme becerisi. Ancak bu beceri artık tek başına yeterli değil; doğrulama araçlarını tanımak, şüpheyle yaklaşmayı alışkanlık haline getirmek ve kurumsal düzeyde güvenlik protokollerini güncellemek de gerekiyor.