“Reality Defender” hesabatında “deepfake” saxtakarlıqlarının artıq korporativ təhlükəyə çevrildiyi vurğulanır.

“Deepfake” saxtakarlığı texnologiyası uzun müddətdir müzakirə mövzusu olsa da, 2025-ci il süni intellektlə işləyən məzmunların "maraqlı texnoloji inkişaf" olmaqdan çıxması və gündəlik biznes proseslərini təhdid edən əməliyyat riskinə çevrildiyi il kimi yadda qalıb. Artıq söhbət yalnız siyasi manipulyasiya və ya məşhurları hədəf alan təhqiramiz məzmunlardan getmir, sintetik media ilə əlaqəli fırıldaqçılıq və etimadın azalması, işə qəbul proseslərindən və bank sistemlərindən tutmuş “qaynar xətt”lərə və korporativ kommunikasiyalara qədər bir çox sahədə baş verir.

Dünyanın aparıcı kibertəhlükəsizlik şirkətlərindən olan “Reality Defender” tərəfindən 2025-ci ilin sonunda dərc edilən "Reality Defender" hesabatında bu cür fırıldaqçılıq faktlarının artıq şirkətlər, hökumətlər və fərdlər üçün sistemli bir təhlükəyə çevrildiyi qeyd olunur.

Bəs bu hal necə bu qədər geniş yayılıb?

Əvvəllər “deepfake” saxtakarlıqlarını yaratmaq qabaqcıl texniki biliklər və güclü aparat tələb edirdi. Bu gün hər kəs asanlıqla əldə edilə bilən proqram təminatlarından istifadə edərək dəqiqələr ərzində inandırıcı audio və ya video məzmunlar istehsal edə bilər. “Deepfake” alqoritmlərindəki inkişaf isə sintetik məzmunu reallıqdan ayırmağı demək olar ki, mümkünsüz edib. Bu cür sərbəstlik özü ilə yanaşı ciddi risklər meydana gətirir. Şəxsi məlumatların oğurluğu, nüfuza xələl gətirmə və hədəflənmiş təqib kimi fərdi təhlükələrdən başqa, “deepfake” saxtakarlıqları artıq maliyyə fırıldaqçılığı, bazar manipulyasiyası, korporativ casusluq və yüksək effektiv sosial mühəndislik hücumları üçün bir vasitəyə çevrilib.

“Deepfake” təhlükəsi 2025-ci ildə artıb

İl ərzində baş verən bir sıra hadisələr “deepfake” saxtakarlıq təhlükəsinin miqyasını ortaya qoyur.

NVIDIA-nın konfransı zamanı “YouTube” sosial şəbəkəsində saxta canlı yayımda şirkətin baş direktoru Jensen Huangın kriptovalyuta fırıldaqçılığını təbliğ edən “deepfake” versiyası nümayiş etdirilib. Saxta yayım 95.000 izləyici, real yayım isə sadəcə 12.000 nəfər tərəfindən izlənilib.

ABŞ-də bir fırıldaqçı, dövlət katibi Marko Rubionu təqlid edən Süni İntellekt tərəfindən yaradılan səsli mesajlar və mətnlərlə yüksək vəzifəli dövlət məmurları ilə əlaqə yaratmağı bacarıb. Rəqəmsal kriminalistika üzrə mütəxəssis Hany Faridin "Washington Post" qəzetinə verdiyi məlumata görə, bu tip əməliyyat üçün 15-20 saniyəlik səs yazısı belə kifayətdir.

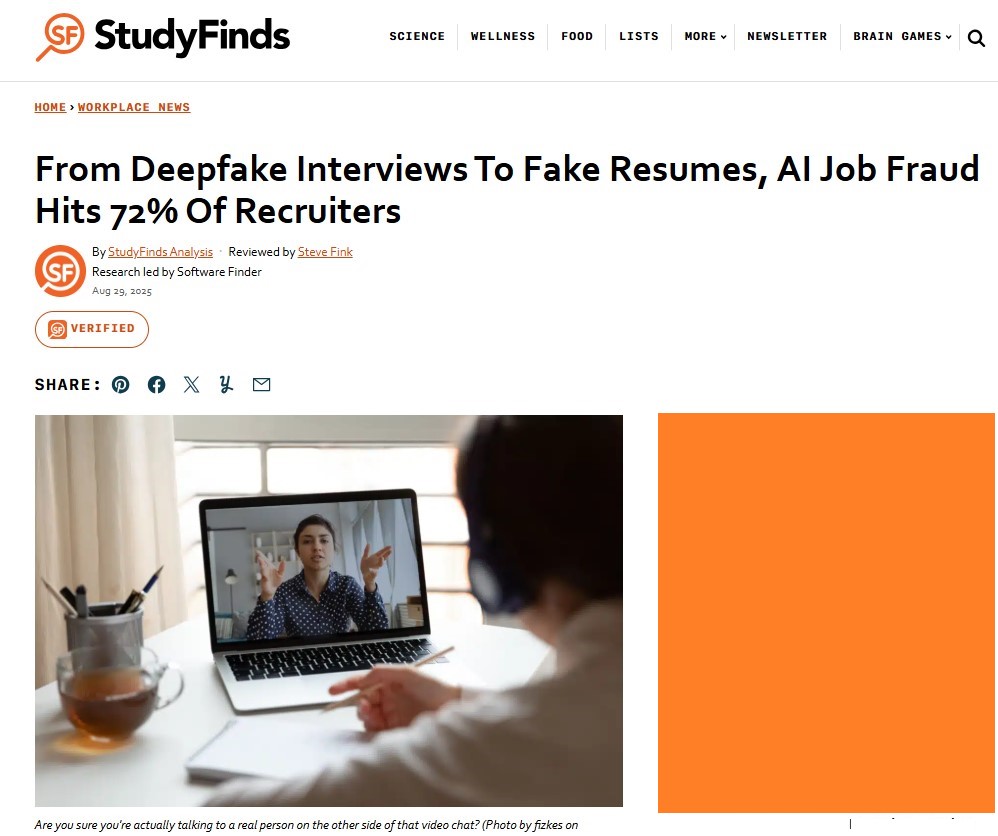

İşə qəbul sahəsində təxminən 900 işəgötürən üzərində aparılan bir araşdırma təəccüblü nəticələr ortaya qoyub. Belə ki, sorğuda iştirak edənlərin 72%-i iş müsahibələri zamanı süni intellekt tərəfindən yaradılan CV-lərlə, 51%-i Süni İntellekt tərəfindən yaradılan iş nümunələri ilə və 15%-i “real time” rejimində üztanıma texnologiyası ilə qarşılaşdıqlarını bildiriblər. studyfinds

Beş kritik təhlükə sahəsi

“Reality Defender” hesabatı 2026-cı ildə təşkilatlar üçün təcili tədbirlər tələb edən 5 “deepfake” ssenarisini də müəyyənləşdirib.

-Rəhbərlikdən gələn saxta zənglər

Səs klonlama texnologiyası yüksək vəzifəli rəhbər şəxslərin tonunu, ritmini, vurğusunu və şifahi vərdişlərini heyrətamiz dəqiqliklə təkrarlaya bilər. Tək bir telefon zəngində saxta maliyyə direktoru köçürmə təlimatı verə, məxfi maliyyə məlumatlarını tələb edə və ya yüksək riskli əməliyyatı təsdiqləyə bilər. Məsələn, Honkonqda fırıldaqçılar maliyyə rəhbərinin səsini klonlaşdıraraq təxminən 18,5 milyon dollar dəyərində kriptovalyuta fırıldaqçılığı həyata keçiriblər.

Düzdür, ənənəvi fişinq maarifləndirmə təlimi işçiləri şübhəli e-poçtları müəyyən etmək bacarığına sahib olurlar, lakin onlar rəhbərlərinin səslərindən fərqlənməyən sintetik səsləri müəyyənləşdirə bilmirlər.

- İş müsahibələrində saxta namizədlər

Uzaqdan və hibrid iş modelləri ilə bağlı video müsahibələr standart işə qəbul metoduna çevirdikcə, yeni bir təhlükə ortaya çıxıb. Belə ki, “Gartner” tədqiqat şirkəti 2028-ci ilə kimi dünyada hər dörd işə düzəlmək istəyən namizəddən birinin saxta ola biləcəyini proqnozlaşdırır.

Məsələn, “Reality Defender”, nəzarət altına alınan “Zoom” müsahibəsində "Gary" adlı bir namizədlə təcrübə aparıb. Gary müsahibədə olduqca özünəinamlı və peşəkar görünüb, amma o, real deyildi. Gary, ümumi mövcud vasitələrdən istifadə edərək on dəqiqədən az müddətdə yaradılan “deepfake” idi.

ABŞ Ədliyyə Nazirliyinin son işləri göstərir ki, sintetik (“deepfake”) namizədlər sanksiya tətbiq olunan qurumlara pul köçürmək, həssas sistemlərə daxil olmaq və qara veb-bazarlarda məhsulun satılması üçün etimad toplamaq üçün işə götürülür. Beləliklə, saxta işçi bütün şəbəkələrə giriş imkanı əldə bilər.

-Sintetik şəxsi məlumat saxtakarlığı

Bankçılıq və “fintech” sektorlarında “Müştərini Tanı (KYC)” prosesləri üztanıma, şəxsiyyət yükləmə və ya canlılıq yoxlamaları vasitəsilə uzaqdan yoxlama aparır. Lakin, bu rahat sistemlər də hücumedənlər üçün bir fürsətə çevrilib.

Əksər mövcud KYC sistemləri üzün şəxsə və ya səsin qeydə alınmış səs izinə uyğun olub-olmadığını yoxlasalar da həmin üzün və ya səsin həqiqi olub-olmadığını yoxlaya bilmirlər. Süni intellekt tərəfindən yaradılan media artıq bu sistemlərin etibar etdiyi biometrik nümunələri təqlid edə bilir ki, bu da sintetik şəxsi məlumat saxtakarlarının təhlükəsizlik yoxlamalarını keçməsinə imkan verir.

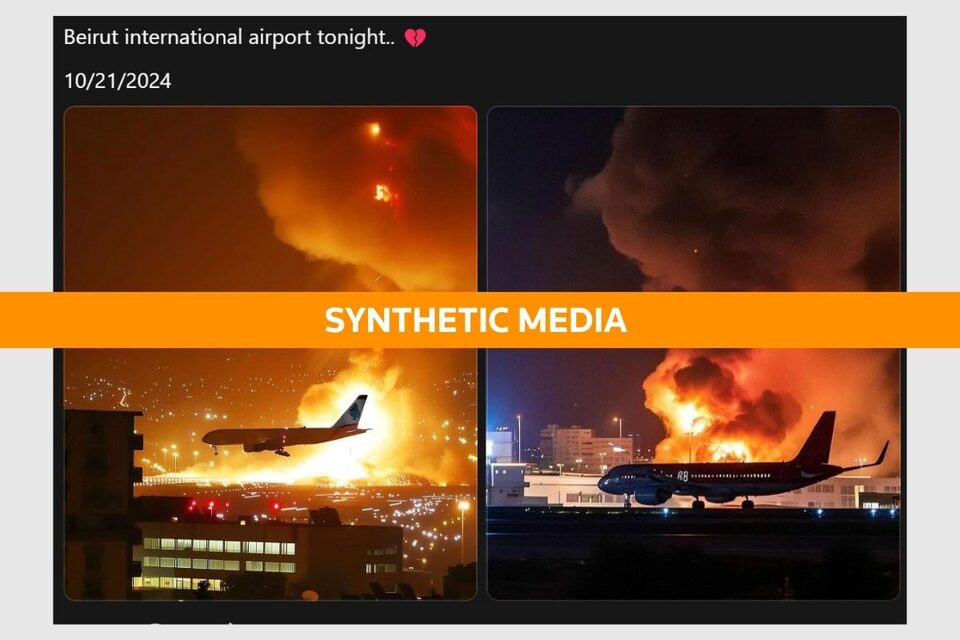

- Dezinformasiyanın sürəti

“SRT”-dən Vinsent Bertyenin qeyd etdiyi kimi, “deepfake” saxtakarlıqları "jurnalistikaya qarşı silah" halına gəlib.

2025-ci ildə Beyrut hava limanına enən təyyarələri göstərən süni intellekt tərəfindən yaradılan görüntülər hava hücumları ilə bağlı yalan iddialarla, mühafizəkar millət vəkili Corc Frimanın Böyük Britaniyada partiyasını dəyişdiyini iddia edən dərin saxtakarlıq videosu ifşa edilməzdən əvvəl viral hala gəldilər.

MIT tədqiqatına görə, yanlış məlumat doğru xəbərlərdən 70 faiz daha çox paylaşılır və doğru xəbərin eyni auditoriyaya çatması altı dəfə daha çox vaxt aparır. Düzəliş dərc olunana qədər yanlış məlumat artıq yayılır.

- “Qaynar xətt” saxtakarlığı

Səs yoxlaması bir vaxtlar etibarlı təhlükəsizlik təbəqəsi idi. İndi isə ən həssas, diqqətə alınmalı olan məqamlardan biridir. Sosial mediadan, video zənglərdən və ya podkastlardan toplanan bir neçə saniyəlik səs yazıları ilə təcavüzkarlar menecerlərin və ya müştərilərin səsləri ilə eyni olan səsləri klonlaşdıra bilirlər.

“Wall Street Journal” müxbiri Joanna Stern öz səsini klonlaşdıraraq müştərisi olduğu bankın şəxsiyyət yoxlamalarını keçməyi bacarıb. “Proofpoint”- in məlumatına görə, maliyyə qurumlarının 99 faizi hesab oğurluğu cəhdləri ilə qarşılaşıb və 62 faizi ən azı bir dəfə pozuntu ilə üzləşib.

Artıq təhdid klonlaşdırılmış səslərdən kənara çıxıb. Müştəri rahatlığı üçün hazırlanmış Süni İntellekt agentləri artıq menyularda naviqasiya etmək, gözləmədə qalmaq, agentlərə təzyiq göstərmək və ləğv təhdidlərini simulyasiya etmək üçün istifadə olunur. Bir çox hallarda agentlər real müştəri ilə, klonlaşdırılmış səslə və ya başqasının adından hərəkət edən Süni İntellekt sistemi ilə danışdıqlarını ayırd edə bilmirlər.

Vəziyyət Ciddidir

“Deepfake” texnologiyası artıq yalnız texnologiya həvəskarlarının və ya təhlükəsizlik mütəxəssislərinin gündəmində deyil. 2025-ci il bu süni məzmunun biznes və hökumətdən, mediaya və bankçılığa qədər hər sahədə sistemli təhlükə yaratdığını sübut etdi.

“Deepfake” təhdidlərinə qarşı ən güclü silah hələ də tənqidi düşüncədir. Lakin, təkcə bu bacarıq artıq kifayət deyil; bu, həmçinin yoxlama vasitələri ilə tanışlığı, şübhəçiliyi vərdiş halına gətirməyi və korporativ səviyyədə təhlükəsizlik protokollarını yeniləməyi tələb edir.